Waktu.news | Siapa yang menduga filosofi favorit Silicon Valley, yaitu longtermisme, bisa memicu perdebatan panas seputar kecerdasan buatan, sampai pada tahap mengkhayal tentang kepunahan manusia?

Namun, kini para kritikus yang semakin vokal menggema, menyatakan bahwa filosofi ini ternyata tak berjalan dengan baik dan bahayanya begitu mencuat, sementara kenyataan yang dihadapi AI adalah pencurian data serta algoritma yang penuh prasangka.

Si penulis Emile Torres, yang dulunya mendukung longtermisme dan kini mengkritik gerakan ini, berkata kepada AFP bahwa filosofi ini sebenarnya dibangun di atas prinsip-prinsip yang dulu digunakan untuk membela pembunuhan massal dan genosida.

Namun, paradoksnya, gerakan ini dan ideologi terkait seperti transhumanisme dan altruisme efektif, ternyata punya pengaruh besar di universitas-universitas kelas atas hingga ke dunia teknologi canggih.

Ada tokoh-tokoh seperti Peter Thiel dan Marc Andreessen yang dengan tegas mendukung perusahaan-perusahaan pemeliharaan umur dan proyek-proyek berkonsepkan gerakan ini.

Tak mau ketinggalan, Elon Musk dan Sam Altman dari OpenAI juga ikut meramaikan panggung dengan menandatangani surat terbuka yang memperingatkan bahwa kecerdasan buatan bisa membawa manusia ke kepunahan – tentu saja, mereka sendiri berpeluang besar mengambil untung dengan argumen bahwa hanya produk mereka yang bisa menyelamatkan kita.

Namun para kritikus tak berdiam diri. Mereka melontarkan pendapat bahwa gerakan ini, yang lebih mirip sekelompok ‘penganut setia’, ternyata punya pengaruh yang terlalu besar dalam perdebatan umum tentang masa depan umat manusia.

“BENAR-BENAR BERBAHAYA”

Para penganut longtermisme mengklaim bahwa kita punya kewajiban untuk berusaha menciptakan hasil terbaik untuk sebanyak mungkin manusia.

Ide ini sendiri tak jauh berbeda dengan paham liberalisme abad ke-19, hanya saja longtermisme menambahkan dimensi waktu yang jauh lebih panjang.

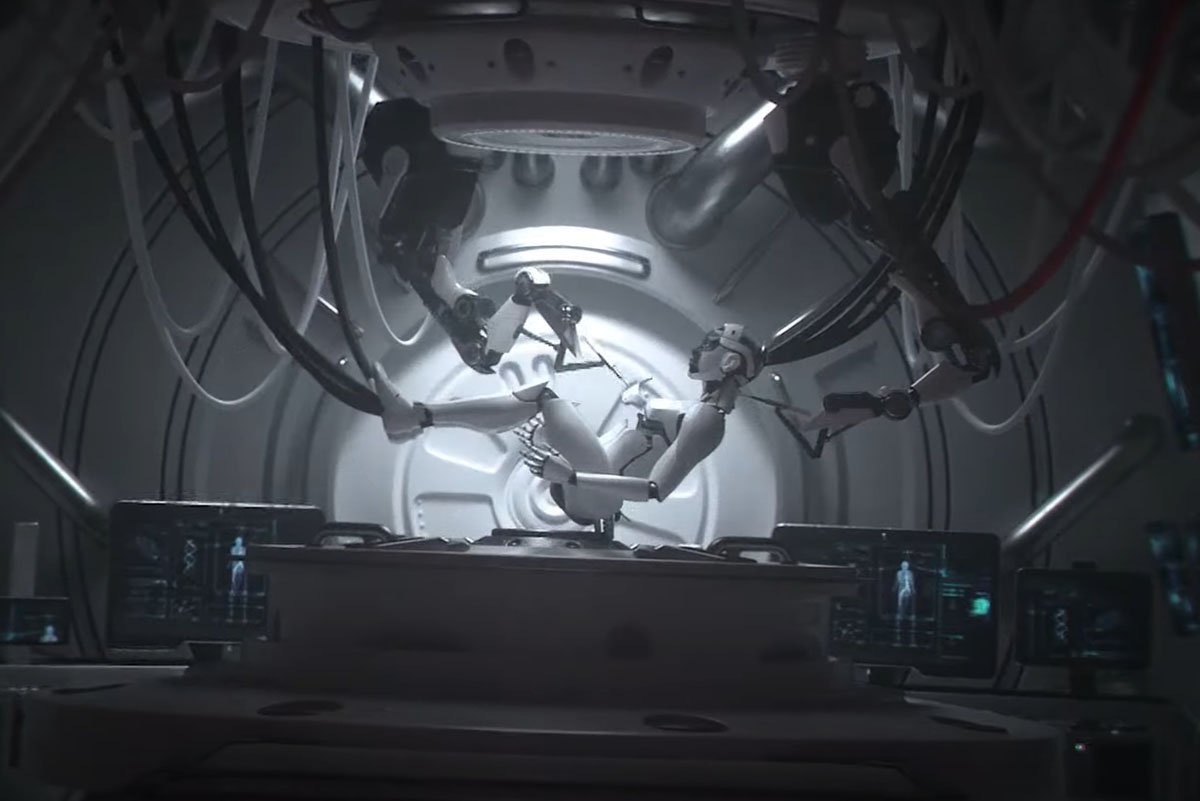

Mereka melihat masa depan yang jauh dan membayangkan triliunan manusia berlayar di ruang angkasa, mengkolonisasi dunia-dunia baru.

Mereka berpendapat bahwa kita punya kewajiban yang sama terhadap setiap manusia di masa depan ini, seperti kewajiban kita terhadap orang yang hidup saat ini.

Karena jumlah mereka begitu banyak, maka suara mereka memiliki bobot yang jauh lebih besar daripada manusia-manusia saat ini.

Namun paradigma semacam ini sebenarnya membawa ideologi ini menjadi “benar-benar berbahaya,” kata Torres, sang penulis Human Extinction: A History of the Science and Ethics of Annihilation.

“Setiap kali ada visi utopis tentang masa depan yang penuh dengan nilai tak terbatas, dan itu dikombinasikan dengan mode pemikiran moral semacam utilitarianisme di mana tujuan bisa membenarkan cara, maka akan sangat berbahaya,” kata Torres.

Jika mesin supercerdas mendekati titik kelahiran dan berpotensi menghancurkan manusia, maka jelas para longtermis akan menentangnya tanpa memedulikan akibatnya.

Pada Maret lalu, ketika seorang pengguna Twitter bertanya berapa banyak orang yang harus mati untuk mencegah kejadian ini, pemikir utama longtermis, Eliezer Yudkowsky, menjawab hanya perlu ada cukup banyak orang “untuk membentuk populasi reproduksi yang dapat bertahan.”

“Mau berapa pun jumlahnya, selama itu benar, masih ada peluang mencapai bintang-bintang suatu hari nanti,” tulisnya, walaupun pesan tersebut kemudian dihapus.

DILEMA EUGENIKA

Longtermisme berakar dari karya filsuf Swedia, Nick Bostrom, pada tahun 1990-an dan 2000-an, yang berkaitan dengan risiko eksistensial dan transhumanisme – gagasan bahwa manusia bisa ditingkatkan melalui teknologi.

Timnit Gebru, seorang akademisi, telah menunjukkan bahwa transhumanisme sejak awal terkait dengan eugenika.

Julian Huxley, seorang biologis Inggris yang menciptakan istilah transhumanisme, ternyata juga pernah menjadi presiden British Eugenics Society pada tahun 1950-an dan 1960-an.

“Longtermisme sebenarnya adalah eugenika dengan nama yang berbeda,” tulis Gebru dalam platform X tahun lalu.

Bostrom sendiri sudah lama dihadapkan pada tuduhan mendukung eugenika setelah ia mencantumkan “tekanan diskogenik” sebagai risiko eksistensial, yang pada dasarnya adalah kelompok manusia yang kurang cerdas berkembang biak lebih cepat daripada kelompok yang lebih pintar.

Filsuf yang mengepalai Future of Life Institute di University of Oxford ini pada bulan Januari meminta maaf setelah mengakui bahwa dia pernah menulis postingan-postingan berbau rasial di forum internet pada tahun 1990-an.

“Apakah saya mendukung eugenika? Tidak, bukan dalam pengertian yang umum dipahami,” tulisnya dalam permintaan maafnya, dengan menunjukkan bahwa istilah tersebut pernah digunakan untuk membenarkan “beberapa kekejaman paling mengerikan dalam sejarah abad terakhir.”

“SANGAT MENYITA PERHATIAN”

Meskipun ada kontroversi yang mengelilinginya, tokoh-tokoh seperti Yudkowsky, yang dikenal karena pernah menjadi dropout sekolah menengah dan menulis fan-fiksi Harry Potter serta mempromosikan poliamori, tetap menjadi pusat perhatian.

Sam Altman bahkan memberinya penghargaan atas dana yang berhasil diajukan untuk OpenAI dan pada bulan Februari mengusulkan bahwa Yudkowsky pantas mendapatkan Hadiah Nobel Perdamaian.

Namun Gebru, Torres, dan banyak orang lainnya tetap berusaha memusatkan perhatian pada dampak negatif seperti pencurian karya seniman, bias, dan konsentrasi kekayaan di tangan beberapa korporasi besar.

Torres, yang memilih menggunakan kata ganti mereka, berkata bahwa walaupun ada penganut yang benar-benar meyakini seperti Yudkowsky, sebagian besar perdebatan seputar kepunahan sebenarnya didorong oleh motif keuntungan.

“Berbicara tentang kepunahan manusia, tentang bencana nyata di mana semua orang mati, jauh lebih menggugah perhatian dan menarik daripada pekerja Kenya yang hanya dibayar US$1,32 per jam, atau seniman serta penulis yang dieksploitasi,” katanya.